近日,中国科学技术大学信息科学技术学院的王子磊副教授在弱监督时序动作检测方向取得了新进展。该研究团队指出把无监督中效果显著的对比学习应用在弱监督时序动作检测时,由于缺少细致的帧级标签,无法准确定义正负样本,为此提出一种新的适用于弱监督时序动作检测任务的正负样本选择方式。相关成果以“Actionness Inconsistency-Guided Contrastive Learning for Weakly-Supervised Temporal Action Localization”为题发表在人工智能顶级国际会议AAAI2023。

时序动作检测任务是预测视频中动作的开始时间和结束时间,并对其进行分类,视频中的动作实例数目不定,一条视频中可能出现多种动作类别。近年来,视频数据井喷式增长,时序动作检测成为了计算机视觉中的一个热门方向。但是对于全监督时序动作检测来说,所有的样本视频都需要人工进行帧级的标注,这种标注工作耗时严重,而且精度普遍不高。因此,为了解决标注难的问题,弱监督时序动作检测应运而生。这种方法可以将网络上大量的未剪辑的视频打上一个视频级的标注,直接作为模型的训练数据。

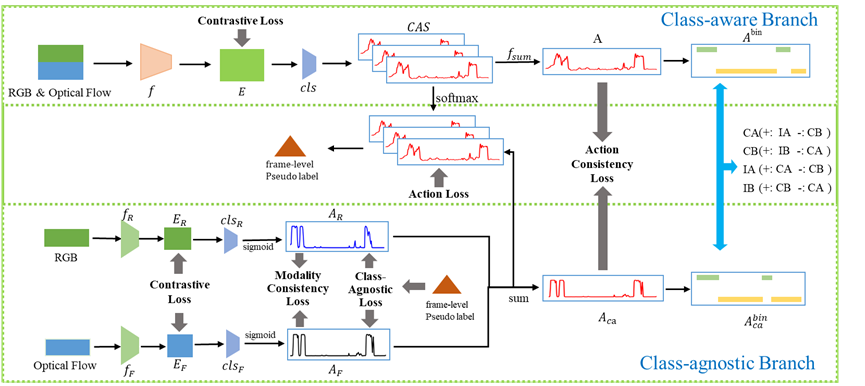

先前的工作如CoLA,通过使用网络预测的粗略动作分数来划定初始动作边界,然后通过对动作边界的膨胀腐蚀操作,选择出动作边界的Hard样本和置信度偏高的Easy样本,但是由于粗略的动作得分得到的初始动作边界误差较大,这样就容易导致选择出的Hard样本不够准确,从而减弱了对比学习的效果。VIM研究组提出利用两个不同分支(如图1中的class-aware 和 class-agnostic)的动作预测,来找出一致性动作/背景片段和不一致性动作/背景片段。不一致性片段具有一定的模糊性,容易被错误分类,影响最终的动作定位,而一致性片段可信度较高,一般来说对它们的动作/背景二分类的准确度较高。利用可信度较高的片段去促进模糊片段的特征学习,并使一致性片段中的动作/背景特征尽量远离,以此来促进所有片段的特征学习。

图 1 模型结构图

VIM研究人员在三种主流的公开数据集THUMOS14,ActivityNet1.2以及ActivityNet1.3上都超越了当前SOTA,平均mAP达到了46.4%(IoU 0.1~0.7),29.9%(IoU 0.5~0.95),27.6%(IoU 0.5~0.95)。

中国科学科学技术大学先进技术研究院硕士研究生李志林为该论文第一作者,中国科学技术大学信息科学技术学院王子磊副教授,为该论文的通讯作者和第二作者,中国科学技术大学信息科学技术学院博士研究生刘钦颖为第三作者。该研究得到了国家自然科学基金的支持。

论文地址:AAAI2023-AICL

代码地址:https://github.com/ lizhilin-ustc/AAAI2023-AICL