近期,中国科大视觉与多媒体研究组与中科院自动化所谭铁牛院士课题组在多模态模型参数高效微调方向取得新进展。在该工作中,团队研究出了一种无须训练的模型微调方法,能够以极低成本提升模型在下游任务上的性能。相关成果以“A Hard-to-Beat Baseline for Training-free CLIP-based Adaptation”为题,发表在机器学习领域顶级会议ICLR 2024上。

随着预训练视觉语言模型的不断发展,它的通用性和泛化性得到广泛认可,人们投入了大量精力对其进行微调以适应下游任务。尽管如此,传统微调过程通常需要消耗额外的计算资源进行进一步训练,这在许多资源受限的应用场景中带来不小的挑战。

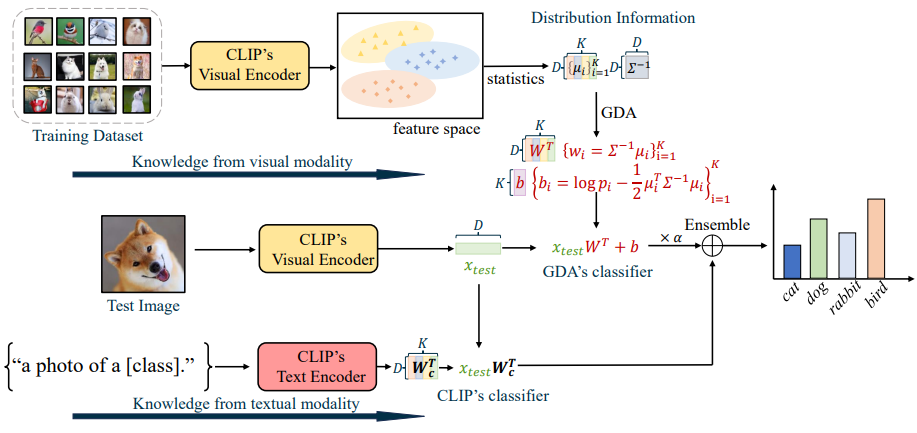

图1 无须训练模型微调方法示意图

在本文,我们提出了一种无须训练的模型微调方法,该方法只需要统计下游数据集基本的统计信息即可提升模型在该任务上的性能。通过应用贝叶斯公式,我们发现模型线性层的参数可以通过输入数据的统计信息进行表征。基于这一原理,我们能够通过计算下游任务输入数据的统计特征,获得该任务相关的线性层表示,从而无需额外的训练步骤。大量实验表明,我们的方法在小样本、长尾分布、无监督、分布偏移和新类泛化等场景中,均显著提升了模型的性能,甚至超越了许多需要额外训练的传统方法。

中国科学技术大学博士生王政博为本文第一作者,中科院自动化所梁坚研究员为论文通讯作者。该工作得到了国家自然科学基金委的资助。

论文链接:https://arxiv.org/abs/2402.04087

代码链接:https://github.com/mrflogs/ICLR24