近日,VIM研究组在图像分类任务的域适应学习方向取得了新进展。团队分析了在无监督学习中常用的实例对比损失应用到域适应任务中存在的两个问题,并提出了低置信度样本和类别关系增强的特征表示的方案,这项研究在域适应图像分类领域达到了当前的SOTA效果。相关成果以“Towards Effective Instance Discrimination Contrastive Loss for Unsupervised Domain Adaptation”为题发表于计算机视觉顶级国际会议ICCV2023。

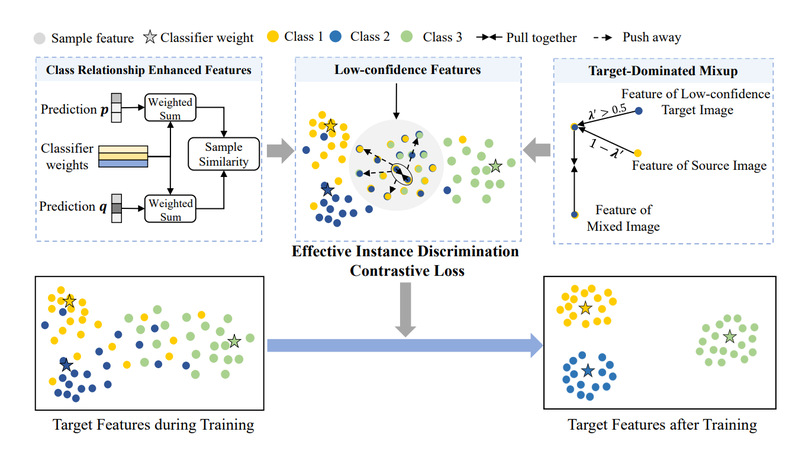

图1 方法思路示意图

域适应(DA)旨在将知识从标签丰富的源域转移到相关但标签稀缺的目标域。近年来,越来越多的研究集中在探索目标域的数据结构。由于实例对比损失(Instance Discrimination Contrastive Loss)在自监督学习中取得了很好的效果,研究人员尝试将其直接应用于领域适应任务。然而,直接使用带来的提升非常有限,这促使研究人员重新思考其对领域适应任务的潜在限制。

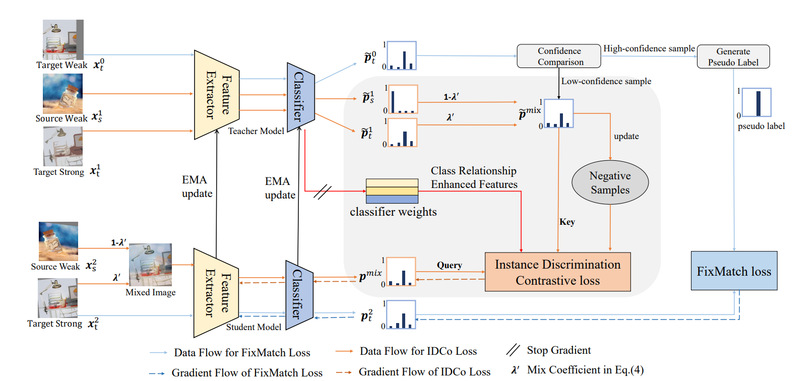

首先,一个比较直观的问题是在实例对比损失中,属于同一类的一对样本可以被视为负例。研究人员通过分析认为使用低置信度样本构建正负对可以缓解这个问题并且更适合IDCo损失。 另一个问题是IDCo 损失无法捕获足够的语义信息。通过从分类器权重和输入数据引入域不变且准确的语义信息来解决这个问题。 具体来说,提出了类关系增强的特征表示方法, 它使用概率加权的类原型作为IDCo损失的输入特征,可以隐式地传递域不变的类关系。 为了引入更多语义信息,进一步提出了一种目标主导的跨域混合,可以合并来自源域的准确语义信息。研究人员在单源域无监督域适应、半监督域适应、多源域无监督域适应等设置中评估了所提出的方法,大量的实验结果表明所提出的方法可以使IDCo 损失更加有效并实现最先进的性能。

图2 论文方法框架示意图

我校信息科学技术学院的博士后张燚鑫为本论文第一作者,王子磊副教授为论文通讯作者,作者还包括已经毕业的博士李俊杰、庄嘉帆和博士生林子涵。该工作得到了国家自然科学基金委、安徽省科技厅和中国科学技术大学创新团队培育基金的资助。

论文地址:ICCV2023